[인공지능] Bayesian Networks - 2

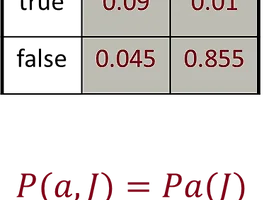

Variable Elimination: The Basic Ideas 가능한 한 안쪽으로 합을 이동합니다. 𝑃(𝐵| 𝑗, 𝑚)=𝛼∑2_(𝑒,𝑎)▒〖𝑃(𝐵)𝑃(𝑒)𝑃(𝑎|𝐵,𝑒)𝑃(𝑗|𝑎)𝑃(𝑚|𝑎)〗 =𝛼𝑃(𝐵)∑2_𝑒▒〖𝑃(𝑒)∑2_𝑎▒〖𝑃(𝑎|𝐵,𝑒)𝑃(𝑗|𝑎)𝑃(𝑚|𝑎)〗〗 내부에서부터 계산을 수행합니다. 즉, 먼저 𝑎에 대한 합을 계산하고, 그 다음에 𝑒에 대한 합을 계산합니다. 문제: 𝑃(𝑎|𝐵,𝑒)는 하나의 숫자가 아니라, 𝐵와 𝑒의 값에 따라 다른 숫자들의 모음입니다. 해결책: 이를 다차원 배열로 사용하고, 적절한 연산을 수행합니다. 이러한 배열은 "팩터(factors)"라고 불리며, 다양한 차원을 가진 숫자들의 모음을 나타냅니다. 변수 제거(Variable Elimination)는 확률 그래..

[인공지능] Bayesian Networks - 2

Variable Elimination: The Basic Ideas 가능한 한 안쪽으로 합을 이동합니다. 𝑃(𝐵| 𝑗, 𝑚)=𝛼∑2_(𝑒,𝑎)▒〖𝑃(𝐵)𝑃(𝑒)𝑃(𝑎|𝐵,𝑒)𝑃(𝑗|𝑎)𝑃(𝑚|𝑎)〗 =𝛼𝑃(𝐵)∑2_𝑒▒〖𝑃(𝑒)∑2_𝑎▒〖𝑃(𝑎|𝐵,𝑒)𝑃(𝑗|𝑎)𝑃(𝑚|𝑎)〗〗 내부에서부터 계산을 수행합니다. 즉, 먼저 𝑎에 대한 합을 계산하고, 그 다음에 𝑒에 대한 합을 계산합니다. 문제: 𝑃(𝑎|𝐵,𝑒)는 하나의 숫자가 아니라, 𝐵와 𝑒의 값에 따라 다른 숫자들의 모음입니다. 해결책: 이를 다차원 배열로 사용하고, 적절한 연산을 수행합니다. 이러한 배열은 "팩터(factors)"라고 불리며, 다양한 차원을 가진 숫자들의 모음을 나타냅니다. 변수 제거(Variable Elimination)는 확률 그래..